Los logs de una web son registros detallados en el servidor de todas las solicitudes y transacciones que ocurren en un sitio web. Estos registros incluyen información como la fecha y hora de la solicitud, la dirección IP del visitante, la página solicitada, el código de respuesta HTTP y otros detalles relevantes. Estos registros son recogidos en nuestro servidor en los conocidos como archivos logs.

Contenidos del post

Herramienta para el análisis de logs: Screaming Frog Log File Analizer

Screaming Frog Log File Analyser es una herramienta de análisis de archivos de registro de un sitio web. Funciona importando archivos de registro de un servidor web y analizándolos para obtener información valiosa sobre cómo los robots y los usuarios interactúan con un sitio web.

Diferencias a tener en cuenta entre la versión gratuita y la de pago de Screaming Frog Log File Analyzer:

Versión gratuita:

- Es una versión limitada y no proporciona todas las funciones y características de la versión de pago.

- Solo se pueden analizar hasta 1000 líneas de registro.

- No se pueden guardar los resultados y configuraciones de análisis para su uso posterior.

Versión de pago:

- Proporciona acceso a todas las funciones y características de la herramienta, incluyendo la posibilidad de analizar archivos de registro de mayor tamaño.

- Permite guardar y recuperar los resultados y configuraciones de análisis para su uso posterior.

- Ofrece informes detallados y personalizados.

- Tiene soporte técnico y actualizaciones de software.

Con esta herramienta, puedes ver cuántos robots o usuarios están accediendo a su sitio, cuántas páginas están siendo rastreadas, qué tipo de peticiones están recibiendo, entre otros. Esta información puede ser valiosa para mejorar el SEO de un sitio web, identificar problemas técnicos (rastreo, 404, 500…), optimizar la velocidad de carga y mejorar la experiencia del usuario en general.

El funcionamiento de Screaming Frog Log File Analyser es muy sencillo, solo debes importar los archivos log en la herramienta y analizarlos. Una vez importados la interfaz es muy similar a Screaming Frog, esdecir, podrás navegar entre diferentes informes, personalizados y filtrar los datos para ayudarte a concentrarte en las áreas/bots que te interesen.

Cómo obtener los archivos logs de mi web

El sistema más común es accediendo a ellos directamente en el servidor, si dispones de acceso al servidor donde se encuentra el sitio web, puedes acceder a los archivos de registro directamente mediante una cuenta FTP o desde el propio CPanel.

La ubicación exacta de la carpeta de registros en un servidor puede variar dependiendo del sistema operativo y la configuración del servidor. Éstas son algunas ubicaciones comunes:

- Servidor Apache: la carpeta de registros de Apache suele encontrarse en /var/log/apache2 o /usr/local/apache2/logs.

- Servidor Nginx: la carpeta de registros de Nginx suele encontrarse en /var/log/nginx o /usr/local/nginx/logs.

- Servidor IIS: la carpeta de registros de IIS suele encontrarse en C:\inetpub\logs\LogFiles.

- Servidor cPanel: la carpeta de registros de cPanel suele encontrarse en /usr/local/cpanel/logs.

Una vez descargados, ya podremos utilizar cualquier programa de visualización de logs con el que poder comprender y estudiar de una manera más fácil los eventos que los diferentes bots han tenido con nuestro servidor. Estos eventos pueden ser errores de rastreo, respuestas del servidor, fecha de rastreo, entre otros.

En algunos servidores Apache solo se genera un archivo llamado error logs que por defecto no cuenta con la información sobre los agentes, esto dice la documentación oficial de Screaming Frog sobre el tema:

El formato de registro común de Apache (CLF) suele ser el formato predeterminado configurado para muchos servidores web diferentes.

Desafortunadamente, este formato no proporciona un campo de Agente de usuario que es una parte integral del análisis proporcionado por el Analizador de archivos de registro.

Tendrá que volver a configurar o pedirle al administrador del servidor web que vuelva a configurar la cadena de formato de registro para proporcionar el campo de agente de usuario.

Esta es la línea típica de formato de registro NCSA requerida:

“%h %l %u %t \”%r\” %>s %b \”%{Referer}i\” \”%{User-agent}i\” “

Screaming Frog Log File Analizer: Guía de uso

1.- Importar los datos a Screaming Frog Log File Analyser

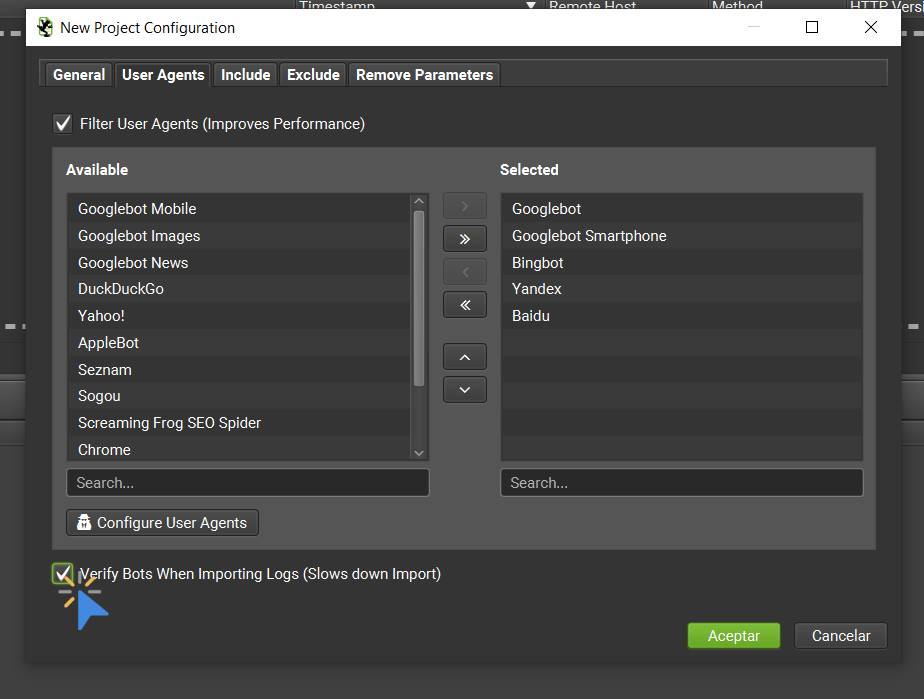

El primer paso que deberemos hacer es importar nuestros archivos de log a Screaming Frog Log File Analyser, para ello crearemos un nuevo proyecto y lo nombraremos a nuestro gusto. Cabe destacar que cuando trabajamos con un programa como Screaming Frog Log File Analyser siempre hagamos click en la opción de verificar que los bots que vamos a estudiar sean reales y no simulados. Finalmente solo tendremos que arrastrar o seleccionar los archivos dentro del programa.

No te preocupes si te has olvidado de clicar la casilla de verificar bots al crear el proyecto, siempre podrás hacerlo desde el menú Project / Verify Bots.

Durante la importación de archivos puede que nos salga una ventana de error donde nos pida la url del dominio, aquí mi consejo es copiar y pegar la url completa del dominio.

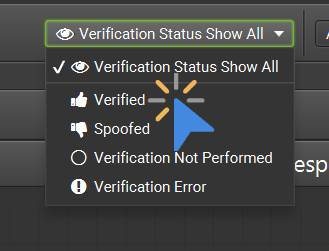

Una vez cargados los datos deberemos seleccionar el filtro de de “Verificados”:

2.- Visualización de Datos

Depende de la configuración del servidor y de la política de gestión de registros de la organización. En algunos casos, los archivos de log se mantienen por un período determinado de tiempo antes de ser eliminados automáticamente, mientras que en otros casos se mantienen indefinidamente hasta que se llenen los recursos de almacenamiento disponibles. Es por ello que puede que no veas un largo periodo de eventos en los reportes de la herramienta, en el caso de querer ampliar el espectro tendrás que cambiar la configuración del servidor.

Una vez cargada la información en la herramienta encontraremos una interfaz muy similar a Screaming Frog, no obstante, nos veremos un nuevo indicador, los eventos.

Los eventos son una entrada que registra una actividad específica en el servidor. Los eventos pueden incluir accesos a la página, errores de servidor, solicitudes de recursos, información de la dirección IP del usuario, entre otros. En conclusión, podremos saber las veces que un bot ha nuestras urls y la información que han recogido.

3.- Estudio de logs y ejemplos de uso para el SEO

Es importante destacar que para poder obtener información relevante de este tipo de estudios necesitaremos una web con un gran volumen de páginas, es decir, será recomendable hacer este tipo de acciones cuando nuestra web tenga como mínimo 1.000 urls únicas.

Dicho esto, qué podemos obtener de un estudio de logs que nos ayude a nuestra estrategia SEO?

- Identificación de errores de respuesta: La herramienta puede analizar los archivos de registro para detectar errores de respuesta, como páginas no encontradas (404), errores de servidor (500) y otros errores técnicos que pueden afectar negativamente el SEO de un sitio web.

- Optimización de la velocidad de carga: La herramienta puede analizar el tiempo de respuesta y la velocidad de carga de un sitio web, lo que permite identificar oportunidades de optimización y mejorar la experiencia del usuario.

- Análisis de la actividad del rastreador: La herramienta puede analizar la frecuencia y el volumen de las peticiones de rastreo de los robots, lo que permite comprender cómo los robots están interactuando con un sitio web y cómo se puede optimizar el rastreo para mejorar el SEO.

- Identificación de contenido duplicado: La herramienta puede detectar contenido duplicado y URLs duplicadas, lo que puede afectar negativamente el SEO de un sitio web.

Con este tipo de estudios podremos responder a preguntas como, está accediendo Googlebot a contenidos, CSS o javascript que no nos interesa que rastree y que no hayamos bloqueado en robots? Está respetando Google las directrices de los robots.txt?

Gracias a estos informes podremos comprobar aspectos técnicos de la web así como identificar pérdidas de tiempo de rastreo y optimizar el rastreo.

Otro ejemplo práctico de uso de este informe, es que gracias él podremos ver el número de eventos (solicitudes al servidor) de cada una de las URLS, pudiendo detectar así si Google está accediendo demasiadas veces a un contenido que no es relevante de negocio, por ejemplo, por un excesivo enlazado interno.

Errores de códigos de respuesta en Screaming Frog vs Screaming Frog Log File Analizer

Llegados a este punto seguro que te estás preguntando qué diferencia hay entre los códigos de respuesta mostrados en Screaming Frog Log File Analyser y los que podemos ver, por ejemplo, en Screaming Frog.

La diferencia entre la detección de errores de respuesta en Screaming Frog y Screaming Frog Log File Analyser es que Screaming Frog se enfoca en la detección de errores de respuesta durante el rastreo de un sitio web. Es decir, Screaming Frog simula un useragent como Googlebot y realiza un rastreo de tu sitio, mientras que Screaming Frog Log File Analyser enfoca su análisis en la detección de errores de respuesta a través del análisis de archivos de registro, siendo este mucho más exacto.

Estadísticas de rastreo de Google

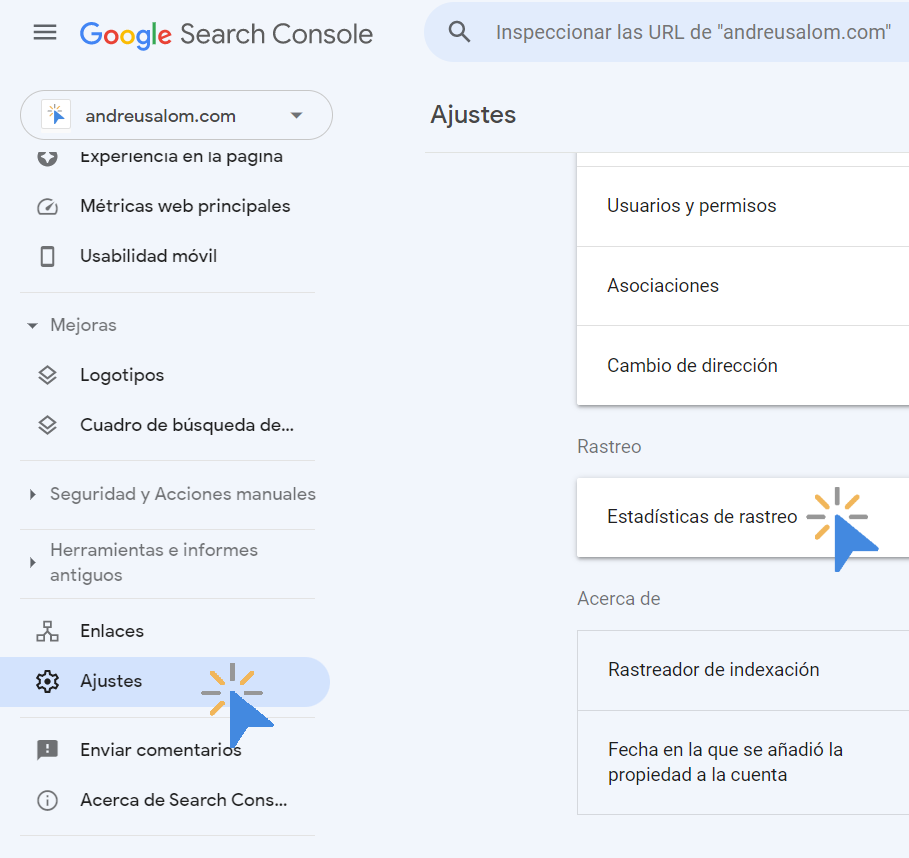

Además de Screaming Frog, Google también ofrece información interesante sobre las estadísticas de rastreo de nuestra web mediante el informe de estadísticas de rastreo de Google Search Console.

Este informe se encuentra dentro de la sección de Ajustes / Estadísticas de rastreo:

A pesar de que la información de este reporte es mucho más limitada, puede ser interesante como información complementaria a los datos de Log File Analyzer. Cabe tener en cuenta que éste solo recoge la información rastreada por los bots de Google, a diferencia de la herramienta anterior que hemos visto que recoge todos.